Với việc lợi dụng công nghệ Deepfake làm giả cuộc gọi video, không ít kẻ lừa đảo đã dễ dàng chiếm đoạt tài sản của người khác.

Bùng nổ thủ đoạn mượn tiền bằng Deepfake

Không còn đơn thuần là gửi tin nhắn mượn tiền, những tên tội phạm mạng thậm chí còn “gọi” video call để mượn và chiếm đoạt số tiền của nhiều người.

Chị V.T.M (26 tuổi ở Long Biên, TP Hà Nội) nhận được tin nhắn mượn tiền từ tài khoản Facebook của một người thân bên nước ngoài. Người này nhờ chuyển 75 triệu đồng tiền vào một số tài khoản. Dù đã cẩn thận gọi video lại để kiểm tra, nhưng chị M. vẫn bị lừa bởi hình ảnh bên kia đúng là bạn mình.

Một thời gian sau, chị V.T.M phát hiện trang cá nhân của người thân đăng thông báo về việc bị kẻ gian hack nick Facebook hỏi vay tiền một số bạn bè và người thân. Khi gọi điện lại, chị M. mới biết mình bị lừa.

Tương tự, anh V.Đ.C (42 tuổi ở Cổ Nhuế, TP Hà Nội) bị lừa mất 30 triệu đồng sau cuộc video Deepfake. Cụ thể, sau khi một tài khoản người thân bên nước ngoài nhắn tin mượn tiền với lý do có việc gấp, anh C. nhận được cuộc gọi video thông qua ứng dụng Messenger.

Theo lời anh V.Đ.C, cuộc gọi diễn ra ít giây, anh vẫn thấy được khuôn mặt người thân, cách xưng hô cũng quen thuộc. Tuy nhiên, cuộc gọi này chập chờn. Đầu bên kia sau đó nhắn lại là sóng yếu, không thể gọi video tiếp được nên chuyển sang nhắn tin cho tiện. Vì tin tưởng, anh C. đã chuyển tiền, làm theo hướng dẫn.

Chuyên gia công nghệ Ngô Minh Hiếu, Trung tâm Giám sát an toàn không gian mạng quốc gia (NCSC) cho rằng, bằng việc chiếm đoạt tài khoản Facebook, Instagram…những kẻ xấu đã lợi dụng công nghệ AI để tạo ra hình ảnh sao chép giọng nói. Sau đó, chúng nghiên cứu lịch sử giao dịch, tin nhắn, cách xưng hô… để tạo ra những cuộc gọi giả.

Các nạn nhân đã bị kẻ lừa đảo chủ động nhắn tin mượn tiền trước, sau đó videocall bằng đoạn video Deepfake “chập chờn” mất sóng để tạo sự tin tưởng. Các nạn nhân dễ dàng rơi vào bẫy.

Video Deepfake là gì, hoạt động như thế nào?

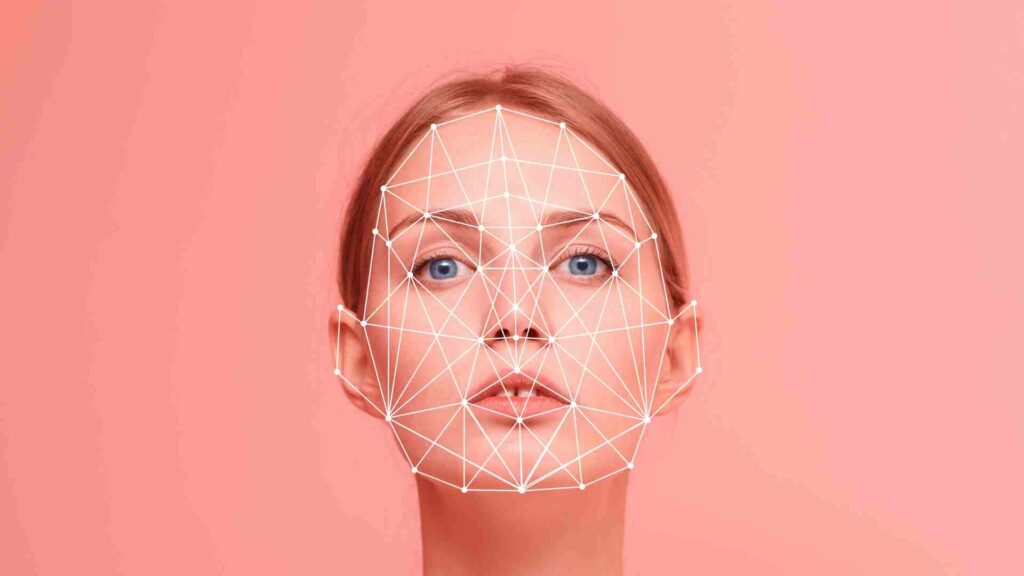

Công an thành phố Hà Nội cho hay, Deepfake là công nghệ sử dụng trí tuệ nhân tạo (AI) nhằm tạo ra các sản phẩm công nghệ âm thanh, hình ảnh, video làm giả đối tượng ngoài đời thực, độ chính xác rất cao.

Với tệp tin hình ảnh khuôn mặt, giọng nói của một người ngoài đời thực, Deepfake sử dụng thuật toán nhằm tái tạo lại khuôn mặt, giọng nói phù hợp với nét mặt, biểu cảm của một người; sau đó tạo ra video có thể giả mạo hoàn toàn đối tượng ngoài đời thực. Các đối tượng thu thập hình ảnh, giọng nói của người dùng trên mạng xã hội thông qua mạng internet, sử dụng công nghệ Deepfake tạo ảnh động, video giả mạo người dùng đang nói chuyện trực tuyến như ngoài đời thực.

Kẻ lừa đảo lập tài khoản giả mạo trên mạng xã hội với thông tin, ảnh đại diện trùng khớp, sau đó kết bạn với nạn nhân trong danh sách bạn bè rồi nhắn tin vay mượn tiền. Cũng có trường hợp kẻ lừa đảo chiếm đoạt luôn tài khoản mạng xã hội của người dùng, rồi trực tiếp nhắn tin với những người trong danh sách bạn bè, biến họ trở thành nạn nhân.

Video Deepfake trở thành “lá bùa” phòng thân để kẻ lừa đảo tạo lòng tin với nạn nhân, khiến họ không mảy may nghi ngờ mà chuyển tiền theo yêu cầu của đối tượng.

Theo Công an thành phố Hà Nội, công nghệ Deepfake đã tạo ra những video giả mạo có độ chính xác cao, rất khó phân biệt thật giả. Tuy nhiên, chúng thường có nội dung chung chung, ngữ cảnh giao tiếp với nạn nhân không thực sự phù hợp nên hoàn toàn có thể phát hiện nếu cảm thấy bất thường. Do đó, để che đi khuyết điểm này, các đối tượng sẽ tạo ra video có âm thanh khó nghe, hình ảnh mờ mịt như đang ở trong khu vực phủ sóng di động/wifi yếu. Thủ đoạn lừa đảo này được đánh giá là rất mới và tinh vi.

Công an thành phố Hà Nội đề nghị người dân cần nâng cao cảnh giác và bình tĩnh khi nhận bất kỳ tin nhắn, cuộc gọi video vay, mượn tiền qua các ứng dụng mạng xã hội. Hãy thực hiện gọi điện thoại hoặc liên lạc trực tiếp cho người thân để xác minh ngay sau đó. Nên nhớ, không gọi xác minh thông qua các ứng dụng mạng xã hội như Zalo, Messenger, Viber, Telegram…

Nếu nghi vấn đối tượng giả mạo người thân trên mạng xã hội để lừa đảo, chiếm đoạt tài sản, cần báo ngay cho cơ quan Công an gần nhất để được hỗ trợ kịp thời, từ đó đấu tranh, ngăn chặn, xử lý nghiêm các đối tượng theo quy định pháp luật.

Cách không bị đánh cắp dữ liệu khuôn mặt và giọng nói

Chuyên gia công nghệ Ngô Minh Hiếu khuyến cáo, để tránh bị làm giả Deepfake, cách tốt nhất là nên hạn chế chia sẻ hình ảnh hay video cá nhân lên trên mạng. Cùng với đó, người dùng luôn cần bảo mật tài khoản mạng xã hội, email bằng mật khẩu có độ khó cao.

Nếu muốn chia sẻ video, clip lên mạng, có thể làm méo tiếng của mình, để tránh trường hợp kẻ xấu biết giọng thật của mình.

Nếu bị làm giả Deepfake, người sử dụng nên thông báo ngay lập tức cho mọi người biết và báo cơ quan chức năng tại địa chỉ canhbao.ncsc.gov.vn hoặc báo lên dự án chongluadao https://chongluadao.vn; đồng thời cần nâng cao nhận thức về nhận biết lừa đảo trên không gian mạng tại: dauhieuluadao.com.

Ông Ngô Tuấn Anh – Chủ tịch HĐQT, CEO Công ty cổ phần An ninh mạng thông minh Smart Cyber Security lưu ý, người dân không bấm vào các đường link lạ. Nếu chuyển tiền, có thể xác minh bằng cách đơn giản và hiệu quả sau: Xem trên ứng dụng internet banking của ngân hàng có hiển thị đúng thông tin người thân, bạn bè khi gõ số tài khoản hay không.

Trong khi đó, anh Ngô Minh Hiếu chỉ một dấu hiệu để nhận biết và phòng tránh cuộc gọi Deepfake khá là đơn giản, đó là quan sát xem khuôn mặt của nhân vật trong video có thiếu tính cảm xúc và “trơ” khi nói chuyện hay không? Nếu thấy tư thế lúng túng, thiếu tự nhiên, hướng đầu và cơ thể không nhất quán thì cần thận trọng, có thể bạn đang đối đầu với siêu lừa đảo đó.